Heute schon angewendet: Datenanalyse und Qualitätssicherung

Die Datenanalyse erfreut sich insbesondere in der Finanzwelt und im Einzelhandel bereits großer Beliebtheit. Viele sind sogar davon überzeugt, dass die Datenanalyse in der modernen Geschäftswelt ein absolutes Muss ist. In der Prozessindustrie sind die Datenmengen, die Datengeschwindigkeit und die Datenvarianz in jüngster Zeit explosionsartig angestiegen. Deshalb stellt sich die Frage, wie sich durch den effizienten Einsatz von fortschrittlichen Datenanalysen (z.B. statistische Analysen, prädiktive Analysen, Big-Data-Analysen etc.) operationelle Risiken reduzieren und Geschäftsergebnisse verbessern lassen. Dieses Thema ist für uns und unsere Kunden von großer Wichtigkeit und erfordert hier und jetzt höchste Aufmerksamkeit.

Wir werden mit immer mehr Billigkonkurrenz aus einer Reihe von Wachstumsmärkten konfrontiert, die einen starken Abwärtsdruck auf die Gewinnspannen ausüben. Eine weitere Herausforderung für die Industrie sind die stets wachsenden Ansprüche der Verbraucher, wodurch wir gezwungen sind, größere Lagerbestände bereitzuhalten, eine kürzere Produktlebensdauer einzukalkulieren und höhere Qualitätsniveaus zu bieten.

Jedes Geschäft birgt Risiken. Manche dieser Risiken wie z.B. Kundenpräferenzen oder Wettbewerbskräfte sind äußerst schwierig einzuschätzen und zu bewältigen. Andere Risiken hingegen wie z.B. operationelle Risiken sind leicht zu begreifen, zu erkennen und zu mindern, was eine erhöhte operationelle Exzellenz, höhere Gewinnspannen, Wettbewerbsvorteile und bessere Kundenbeziehungen zum Ergebnis hat. Operationelle Risiken stehen in direktem Zusammenhang mit fünf allgemeinen Aspekten: Produktqualität, Effizienz, Anlagenzuverlässigkeit, Sicherheit und menschliche Zuverlässigkeit. Dieser Artikel behandelt vornehmlich die Frage, wie eine fortschrittliche Datenanalyse dabei helfen kann, neue Erkenntnisse zum Thema Qualität und Compliance zu gewinnen.

Herausforderung Qualitätssicherung

Viele Unternehmen haben unlängst mit Problemen bei der Qualitätssicherung zu kämpfen, was zu einer Verschwendung von Rohstoffen, zum Rückruf von Produkten und sogar zu einem Imageverlust des Unternehmens führt. Die von unseren Kunden häufig gestellten Kernfragen lauten „Warum wird es immer schwieriger, unsere Qualitätsziele zu erreichen?“ und „Wie können wir im Vorfeld, also vor der Produktauslieferung feststellen, dass etwas mit dem Produkt nicht stimmt?”.

Wir haben zwei zentrale Herausforderungen bei der Qualitätssicherung ermittelt: alternde Anlagen und die steigende Nachfrage nach höherer Qualität und Konsistenz.

Die Anlagen in vielen Unternehmen sind zunehmend veraltet und unzuverlässig. Deshalb wird es immer schwieriger, den Anlagenzustand zu optimieren und die gesteckten Qualitätsziele zu erreichen. Ein weiteres Phänomen ist eine noch nie dagewesene Nachfrage nach hoher Qualität und Konsistenz. Diese Problematik stellt sich sowohl in Westeuropa als auch in Japan, obwohl diese Länder in punkto Qualität und Konsistenz bereits branchenweit eine Spitzenposition einnehmen. Für eine weitere Erhöhung des Qualitätsniveaus müssen Unternehmen ihre Datenbanken durchforsten und alle Daten für die gesamte Produktionsanlage und sämtliche Prozesse prüfen. Allerdings ist eine Identifikation aller qualitätsbeeinflussender Parameter aufgrund der vielzähligen beteiligten Faktoren äußerst komplex und schwierig. Die meisten Unternehmen meinen, sie würden alle Schlüsselvariablen kennen, die für die Qualität ihrer Prozesse und Produkte verantwortlich sind, aber unserer Erfahrung nach ist dies reines Wunschdenken. Dies führt uns unweigerlich zu der folgenden Frage: Wie können wir alternde und zunehmend unzuverlässige Anlagen mit dem Kundenwunsch nach besserer Qualität und Konsistenz in Einklang bringen, wenn es so viele versteckte Qualitätsparameter gibt, die einen starken Einfluss auf die Prozess- und Produktqualität haben?

Yokogawas innovative Lösung zur Qualitätssicherung

Auf der Grundlage seiner langjährigen Erfahrung hat Yokogawa eine innovative Lösung zur Qualitätssicherung entwickelt: Process Data Analytics, eine Anwendungssoftware zur Erkennung von Qualitäts- und Produktivitätsverlusten in einer frühen Phase des Herstellungsprozesses. Dies wird ermöglicht durch die Analyse von Prozessdaten, Anlagenstatusinformationen, der Betriebshistorie und weiteren Daten.

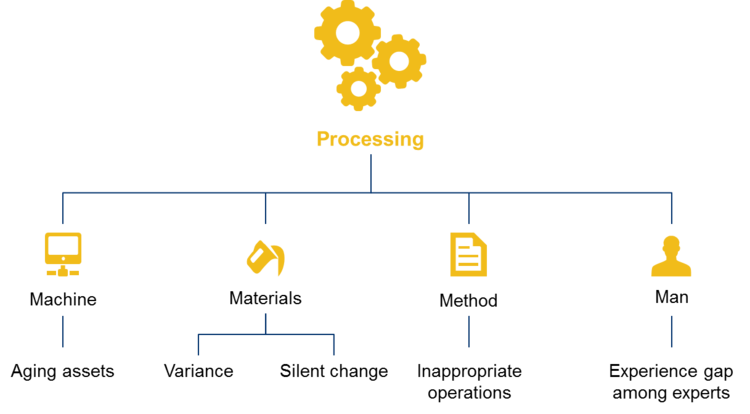

Diese Lösung stellt die Datenverarbeitung und -aufbereitung in den Mittelpunkt und bedient sich einer strukturierten Methode zur Identifikation, Lösung und Modellierung von Produktqualitätsproblemen basierend auf der 4-M-Methode – Mensch, Material, Methode, Maschine (Abbildung 1).

Ein “Zungenbrecher”: Die angewandte Mustererkennungsmethode

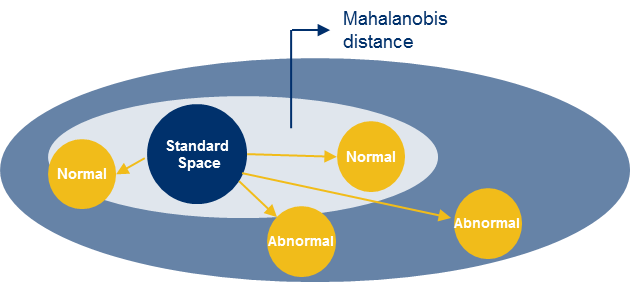

Neben dieser Methode haben wir auch unsere fortschrittliche Datenanalysesoftware entwickelt. Diese branchenführende Lösung verwendet die sog. Mahalanobis-Taguchi-Methode (MT) zur Analyse vielzähliger statistischer Variablen. Bei der MT handelt es sich um eine Mustererkennungsmethode, die in der Qualitätskontrolle und im Qualitätsmanagement weit verbreitet ist.

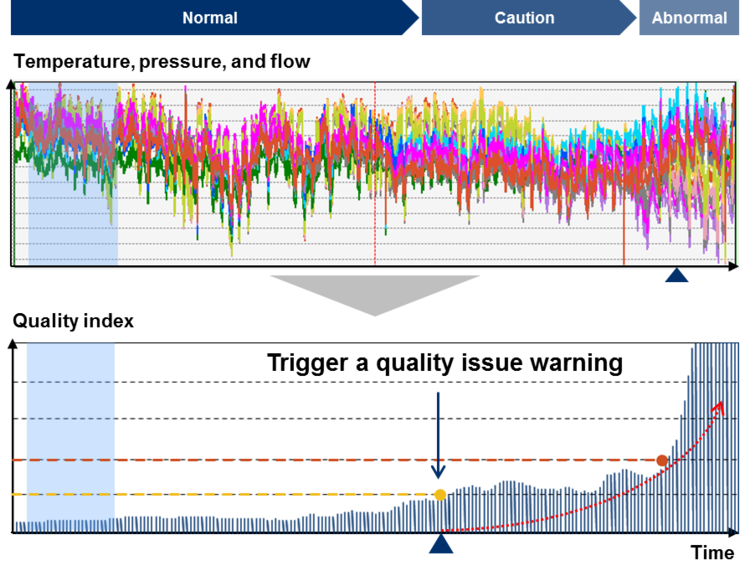

Zunächst wird die Standardabweichung aus zwei oder mehr Datensätzen im Normalzustand ermittelt. Dann werden die verglichenen Datensätze aus den Daten im Vergleichszustand erfasst. Das Grundprinzip beruht auf der Messung der Distanz zwischen der Standardabweichung und den verglichenen Datensätzen unter Berücksichtigung der Wechselwirkungen zwischen den Datensätzen. Die Normalität oder Anomalie des verglichenen Datensatzes wird mit Hilfe dieser Distanz, der sog. Mahalanobis-Distanz, (Abbildung 2) beurteilt. Jede Abweichung von den Normalbedingungen wird erkannt und führt zur Ausgabe einer Warnmeldung zu einem möglichen Qualitätsverlust.

Weit mehr als nur ein Faktor

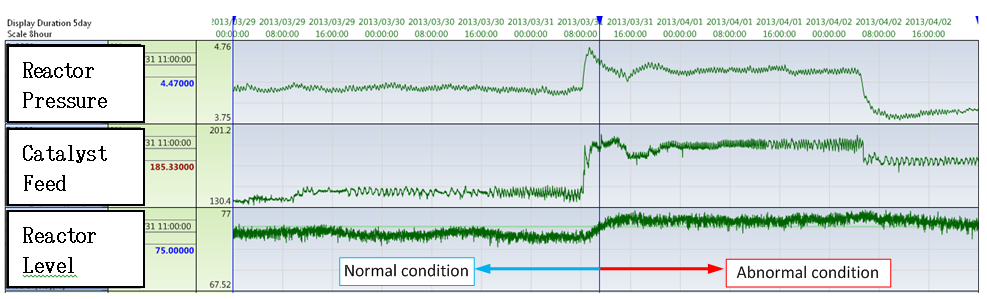

In der Prozessindustrie, insbesondere in der chargenorientierten Prozessindustrie, besteht ein hohes Maß an Anomalien und extrem komplexen Zusammenhängen. Bislang gab es kein so intelligentes und zuverlässiges Früherkennungssystem für Qualitätsprobleme, mit dem Anlagenfahrer durch eine Qualitätserkennung in Echtzeit Betriebsabläufe während der Produktion zielgerichtet unterbrechen oder anpassen konnten. Hier kommt unsere zukunftsweisende Softwarelösung Process Data Analytics ins Spiel: Process Data Analytics analysiert Produktionsabläufe basierend auf Parametern wie Temperatur, Druck, Durchfluss, Füllstand und anderen Prozessdaten sowie Daten zu Anlagenabläufen und Gerätewartung, die von einem PIMS (Prozess-Information-Management-System), DCS (verteiltes Prozessleitsystem) oder PLC (speicherprogrammierbare Steuerung) erfasst werden.

Da Qualität von diversen Faktoren beeinflusst wird, liegt der Schlüssel zum Erfolg in der Umsetzung dieser Lösung, die sämtliche Mitarbeiter über mehrere Abteilungen hinweg zusammenbringt und eine uneingeschränkte Zusammenarbeit ermöglicht. Die meisten Datenanalyseunternehmen am Markt erfassen jedoch lediglich Daten und führen die Datenanalyse hausintern durch, ohne die Betriebsabläufe beim Kunden zu berücksichtigen, wodurch entscheidende Faktoren außer Acht gelassen und falsche Schlussfolgerungen gezogen werden.

Hilfe zur Selbsthilfe

Gängige Praxis ist auch, dass den Kunden die Datenanalysesoftware bereitgestellt wird, sie die Analyse aber selbst durchführen müssen. Diese Art von Software ist in der Regel alles andere als benutzerfreundlich und ihre Verwendung viel zu komplex für nicht hochspezialisierte Anwender. Deshalb wird die Software nach dem Kauf vom Kunden kaum eingesetzt. Yokogawa hat bei der Entwicklung von Process Data Analytics auf eine Kombination aus Datenanalyse und Kenntnissen der Anlagenabläufe beim Kunden gesetzt. Wir verkaufen diese einzigartige Softwarelösung nicht nur, sondern arbeiten in unserer Rolle als Lösungsspezialist eng mit unseren Kunden zusammen und begleiten sie solange, bis sie ihre Qualitätsprobleme eigenständig meistern können.

Im Grunde wissen wir alle, dass eine effiziente Qualitätskontrolle für den Aufbau eines erfolgreichen Unternehmens unverzichtbar ist. Uns allen ist bewusst, welch wichtige Rolle die Qualitätssicherung zur Erzielung von Kostensenkungen und zum Schutz der Vermögenswerte spielt. Aber sind dies wirklich die einzigen Vorzüge einer gleichbleibend hohen Qualität? Viele Unternehmen und sogar die Marktführer in unserer Branche werden diese Frage bejahen. Qualitätskontrollfunktionen werden häufig als unnötiger Mehraufwand betrachtet, wobei sie in manchen Fällen sogar Kostensenkungsmaßnahmen zum Opfer fallen.

„Qualitätskontrolle ist schön und gut, aber nicht besonders attraktiv.”

Stimmt das? Schauen wir uns die folgenden Thesen an:

„Unternehmen, die als Anbieter qualitativ höherwertiger Produkte wahrgenommen werden, erwirtschaften drei Mal höhere Gewinne als andere Unternehmen.”

„Unternehmen können ihre Gewinne um fast 100 % steigern, indem sie ihre Kundenbindung um nur 5 % erhöhen”.

Zu diesen Ergebnissen kommt C. D. Heagy in seiner Studie zu immateriellen Vermögenswerten und ihren Auswirkungen. In der Tat werden die positiven Auswirkungen der Qualitätssicherung auf die Umsatz-/Gewinngenerierung und die Erhöhung der Kundenbindung grundsätzlich unterschätzt oder sogar ignoriert. Wir haben beispielsweise im Rahmen unserer Zusammenarbeit mit einem Reifenhersteller dessen Qualitätsparameter analysiert und gemeinsam ein optimales Lösungskonzept erarbeitet. Aufgrund der stark variierenden Kundenansprüche sind die Qualitätsziele des Reifenherstellers nur schwer umsetzbar. Wir haben in diesem Fall mit Hilfe der sog. Response Surface Methode (RSM) Wirkungsflächenpläne zur Herstellung eines kausalen Zusammenhangs zwischen der Qualität und den Produktionsbedingungen in einer Trade-off-Beziehung erstellt. Durch die Ausführung unserer Analyse ließ sich ein Produktionssystem einrichten, dass eine flexible Anpassung der Produktionsbedingungen an sich wandelnde Qualitätsansprüche der Kunden ermöglicht. Mit unserer analytischen Qualitätssicherungslösung können unsere Kunden die Vertriebsphase beschleunigen und die Wettbewerbsfähigkeit ihrer Produkte verbessern, was letztendlich zu einer deutlichen Erhöhung ihrer Umsätze und Gewinne führt.

So wird es gemacht

Unser Beratungsservice Process Data Analytics wird derzeit von 120 Unternehmen unter Zugrundelegung der folgenden allgemeinen Vorgehensweise genutzt.

Schritt 1: Detaillierte Standortanalyse

- Vollständige Prozessanalyse

- Problemerkennung

- Aufstellung einer Hypothese basierend auf Erfahrungen

- Datenerfassung (z.B. Aufzeichnungen zu Prozessdaten, Qualitätsdaten, Betrieb/Produktion/Wartung etc.)

Schritt 2: Prä-Prozessdaten

- Datenbereinigung

- Merkmalsextraktion aus Daten (z.B. Abbildung 3)

Schritt 3: Statistische Datenverarbeitung und -aufbereitung

- Wahl der geeigneten Methode

- Indexierung der Produktqualität

- Anomalieerkennung/Früherkennung (z.B. Abbildung 4)

Schritt 4: Ursachenanalyse

- Untersuchung der Ursache(n)

- Bestimmung der Ursache(n)

Schritt 5: Berichterstattung

- Empfehlung von Gegenmaßnahmen

- Erstellung eines Berichts

Zusammengefasst

Yokogawas innovative Softwarelösung Process Data Analytics bietet eine Kombination aus fortschrittlicher Datenanalyse und tiefgründigen Prozesskenntnissen, mit der unsere Kunden die Qualität ihrer Produkte sicherstellen und kontinuierlich verbessern können.

Diese Lösung wird zur Kontrolle und Sicherung der Produktqualität in der Ölindustrie, der petrochemischen Industrie, der Zellstoff- und Papierindustrie, der Eisen- und Stahlindustrie, der pharmazeutischen Industrie, der Lebensmittelindustrie, der Automobilindustrie, der Glas- und Gummiindustrie, der Elektro- und Elektronikindustrie und anderen Branchen eingesetzt. Process Data Analytics beinhaltet:

- umfassende Methoden

- eine zukunftsweisende Analysesoftware

- qualifizierte Datenanalysten.

Die Datenanalyse hat die Welt verändert. Wir tun unser Bestes, um das Leben unserer Kunden und der gesamten Gesellschaft mit Hilfe dieser großartigen Technologien zu verbessern. Sind Sie bereit für eine bessere Zukunft?

Bei diesem Post handelt es sich um einen “Re”-Blog. Der ursprüngliche Artikel wurde in englischer Sprache auf dem Advanced Solutions Blog veröffentlicht. Lesen hier weitere spannende Beiträge.